浸没式液冷技术在数据中心的节能应用效果研究

摘要:通过对服务器浸没式液冷实验台的测试,分析不同室外温度和服务器发热功率下系统的制冷PUE(能源使用效率)。结果显示,制冷PUE值在1.05到1.28之间,室外温度39℃,负载功率3.773kW时,制冷PUE最低为1.056。上海市数据中心全年运行制冷PUE为1.060,使用浸没式液冷的数据中心冷却系统能耗仅为传统精密空调的10%。

关键词:数据中心、浸没式液冷、制冷PUE、节能

数据背景

据工信部2019年数据,截至2017年底,我国数据中心机架总规模增长33.4%,大型、超大型数据中心增速68%。2018年中国数据中心总用电量占全国用电量2.35%,未来5年预计增长66%。数据中心电能消耗中,冷却系统约占40%,因此降低冷却系统能耗是关键。

随着单机柜发热功率突破20kW,传统精密空调难以解决高功率和局部热点问题,导致冷却系统能耗过高甚至无法完全散热。浸没式液冷以高换热效率解决这些问题,应用日益广泛。本文将介绍浸没式液冷的换热效率及节能潜力。

实验台与方法

实验台

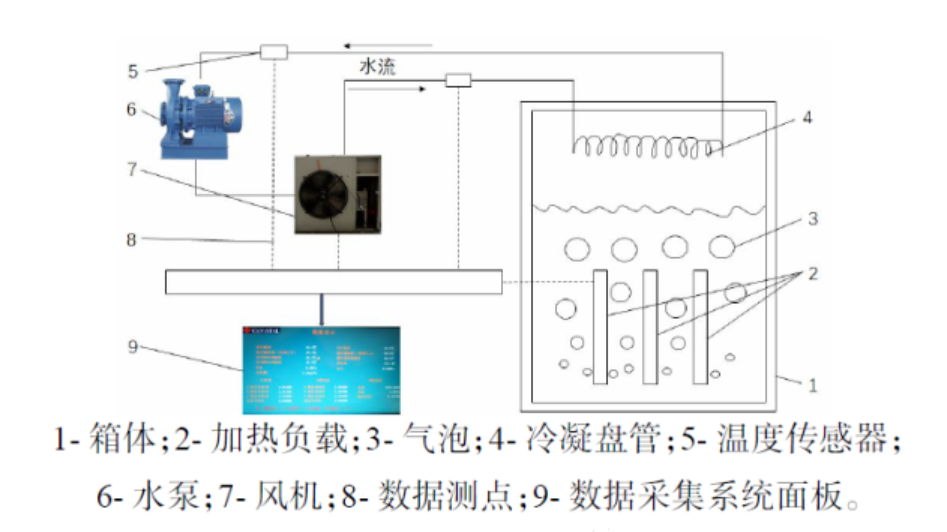

浸没式液冷分为单相和两相两种类型,单相浸没式液冷中的液体在使用过程中不涉及相变过程,而两相浸没式液冷中的液体会在气态和液态中转变。本研究的对象是两相浸没式液冷,实验搭建了用于测试浸没式液冷换热效率的实验台。主要仪器设备有箱体、加热负载、冷凝盘管、风机、水泵、数据采集装置等。实验台示意图如图1。

实验台箱体及内部实验装置、数据采集装置均放置于室内侧环境舱,风机、水泵放置于室外侧环境舱,室内侧和室外侧环境舱均可用空调系统精确控制其空气参数。室内环境舱中尺寸为0.4m×1m×1.4m的箱体,加热负载位于箱体内中下部,冷凝盘管位于箱体上部。箱体内液体能完全浸没加热元件。箱体正面、右侧面和上表面均有部分区域用透明材料制成,方便实验人员观察箱体内实验情况。

实验方法

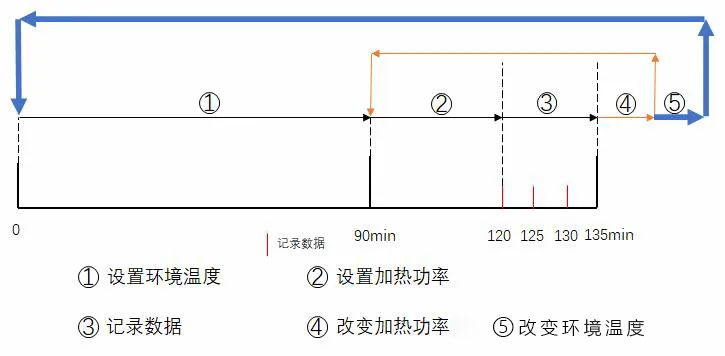

风机和水泵位于室外侧,设置风机频率为20Hz,水泵频率为20Hz。设置风机和水泵频率均为20Hz是由于实验配置的风机和水泵容量较大,而频率可调范围为20Hz到50Hz,通过预实验得到20Hz工况已能满足实验稳定运行。实验流程图如图3所示。

设置室外温度,约90分钟后温度稳定。

设置负载加热功率,等待温度稳定,约30分钟。

每5分钟记录一次数据,共记录3次。

改变负载加热功率,重复步骤2和3。

改变室外温度,重复上述步骤。

上海市最高温度超过35℃的天数平均每年为7.6天,最高温可达40.2℃。此次实验设置了9个温度区间,涵盖最不利天气。

实验仪器

实验仪器技术参数表

| 仪器种类 | 型号 | 精度 |

|---|---|---|

| 热电偶 | PT100 | 0.1℃ |

| 气温测量系统 | - | 0.01℃ |

| 功率计 | DTSD4921 | 0.5级 |

实验结果与分析

实验结果

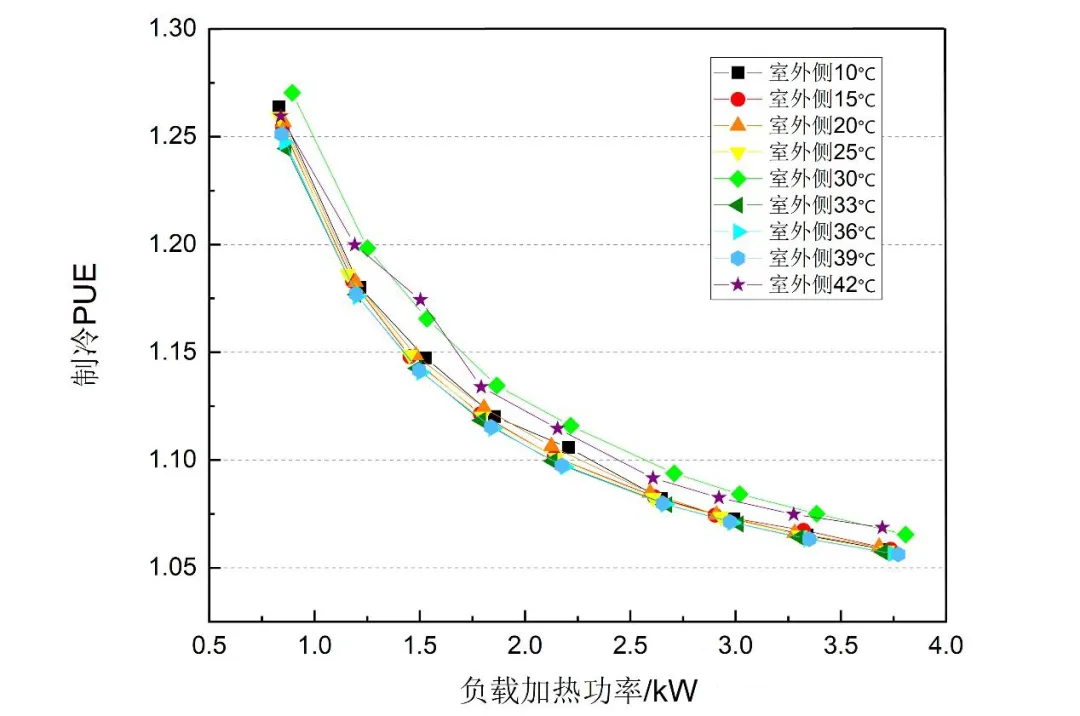

记录不同室外温度下风机和水泵功率及负载加热功率,发现制冷PUE值在1.05到1.28之间(如图4)。在39℃环境下,负载功率3.773kW时,制冷PUE最低为1.056。

负载功率

图展示了42℃时进口水温、出口水温、气体温度随加热功率变化。随着负载加热功率上升,进口水温从42.9℃升高到44.7℃,出口水温从43.9℃升高到52.7℃,气体温度维持在60.5℃。

全年制冷PUE计算

数据中心的能耗主要由IT设备能耗,制冷设备能耗,供配电系统能耗,照 明及其他能耗组成,数据中心PUE的计算如下式:

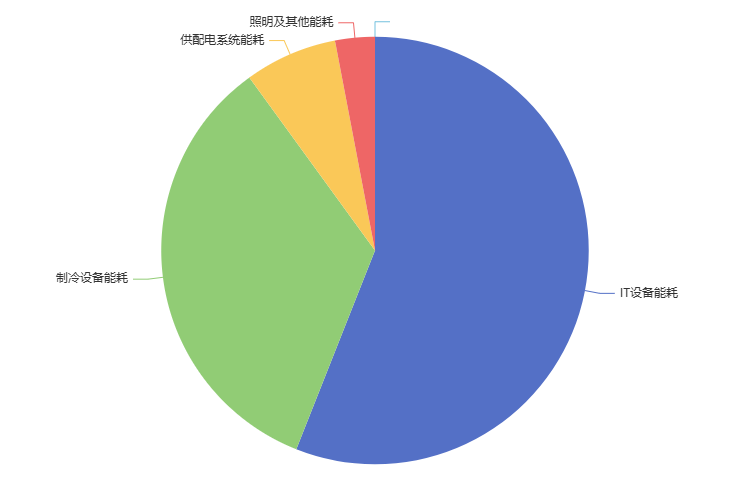

关于数据中心能耗的构成比例,学者做了大量的调查与研究。虽然研究结果中各部分占比不尽相同,但能耗构成种类及排序基本相同。根据文献[3-7]中数据中心的容量以及能耗构成比例可以得出,使用传统精密空调的数据中心总能耗中,IT设备能耗占比最高,约为56%。其次是制冷系统能耗,约占34%。再其次是供配电系统能耗,约占7%,其中最主要的是UPS设备的能耗,次之是变压器设备的能耗。最后是照明及其他能耗,约占3%。这里的其他能耗主要包括:安防设备,消防设备,电梯,传感器以及数据中心管理系统的能耗等。综合了论文中数据得出,PUE值为1.786,其中制冷PUE值为1.609。使用传统精密空调的数据中心能耗构成如图所示。

本文得出的是某一室外侧温度、负载加热功率下的制冷PUE,评价数据中心能源利用效率的指标是全年制冷PUE,因此需要用制冷PUE得出全年制冷PUE,具体公式如下:

数据中心能耗主要由IT设备、制冷设备、供配电系统、照明及其他能耗组成。根据文献,使用传统精密空调的数据中心,IT设备能耗占比56%,制冷系统34%,供配电系统7%,照明及其他3%。计算得出传统空调PUE为1.786,其中制冷PUE为1.609(如图6)。

采用上海市气象文件,将天气根据温度分为8个级别,与实验数据相对应,分别为10、15、20、25、30、33、36、39℃。对应关系如表

| 10℃ | 15℃ | 20℃ | 25℃ | 30℃ | 33℃ | 36℃ | 39℃ | |

|---|---|---|---|---|---|---|---|---|

| 温度区间 | 10℃以下 | 10-15℃ | 15-20℃ | 20-25℃ | 25-30℃ | 30-33℃ | 33-36℃ | 36-39℃ |

| 小时数/h | 2351 | 1185 | 1298 | 1711 | 1572 | 404 | 206 | 33 |

| 制冷PUE | 1.058 | 1.059 | 1.060 | 1.058 | 1.065 | 1.057 | 1.057 | 1.056 |

由式表得到上海地区全年制冷PUE为1.060,远低于论文中使用传统精密空调的数据中心全年制冷PUE-1.609,制冷能耗降低幅度高达90.2%。

结论

本文通过对浸没式液冷实验台进行测试,得出以下结论:

不同温度和相同功率下,制冷PUE基本相同。

制冷PUE随负载功率上升而降低,最大值为1.270(30℃,0.895kW),最小值为1.056(39℃,3.773kW)。

上海市数据中心全年制冷PUE为1.060,相比于使用传统精密空调的数据中心,能耗降低90.2%。

[1] 国家工业和信息化部. 全国数据中心应用发展指引[R]. 2018

[2] 国际环保组织绿色和平,华北电力大学. 点亮绿色云端:中国数据中心能耗与可再生能源使用潜力研究[R]. 2020

[3] Luo Y, Andresen J, Clarke H, et al. A 'System' Integration for Energy Recovery within Data Centres Using Combined Cooling and Power Technology[J]. Procedia Manufacturing, 2018, 21: 710716.

[4] Choo K, Galante R M, Ohadi M M. Energy consumption analysis of a mediumsize primary data center in an academic campus[J].Energy and Buildings, 2014, 76(Jun.): 414421.

[5] 宫晔, 钟世民,韩海泉.大连市某数据中心空调系统节能设计及经济分析[J]. 建筑热能通风空调, 2017, 36(10): 5660+99.

[6] 吴冬青, 吴学渊. 间接蒸发冷凝技术在北疆某数据中心的应用[J]. 暖通空调, 2019, 49(8): 7276.

[7] 付显学. 数据中心节能技术应用[J]. 农村经济与科技, 2018, 29(13): 298300.

探索更多,携手共赢

如有任何问题、反馈或合作意向,请直接点击下方按钮。我们期待与您建立联系,共创美好未来。

相关资讯