一周科技速览:新显卡、AI PC与芯片创新引领未来

导语:

本周,科技界迎来了一系列重磅新闻。从显卡到AI技术,再到芯片创新,多个领域都在快速发展,推动着技术的前沿进程。

Intel锐炫B580独显曝光,带来了更高频率和更大显存的提升,尽管在带宽上略有降低,但整体性能仍然值得期待。与此同时,NVIDIA的RTX 50系列显卡显存采用了三星的GDDR7,预计将大幅提升显卡性能,并为未来的技术进步铺路。

AMD则通过新的多芯片堆叠技术,优化了性能与效率,进一步巩固了其在CPU市场的竞争力。英特尔在AI领域的布局也日益突出,其AI PC在端侧算力上取得飞跃,推动了更多智能应用的落地。

最后,台积电宣布了1.6纳米芯片的突破,采用背面供电技术,使芯片性能和功耗进一步优化,展现了未来芯片制造的新方向。

接下来,我们将详细回顾这一周内的科技热点,探讨这些创新如何影响行业发展。

RTX 5090D或将采用新“刀法”,硬件规格与原版无异

英伟达预计在2025年CES上推出RTX 50系列显卡,其中RTX 5090D将面向中国市场,以绕过美国对高性能显卡的出口限制。不同于以往通过减少核心数等手段调整性能的做法,RTX 5090D可能在硬件配置上与标准版相同,但会通过软件层面如VBIOS来限制某些特定应用(特别是张量运算)的表现,从而不影响游戏性能的同时满足合规要求。此外,RTX 5080及其他型号也将在第一季度陆续发布,建议消费者等待新产品上市或关注老款促销情况。

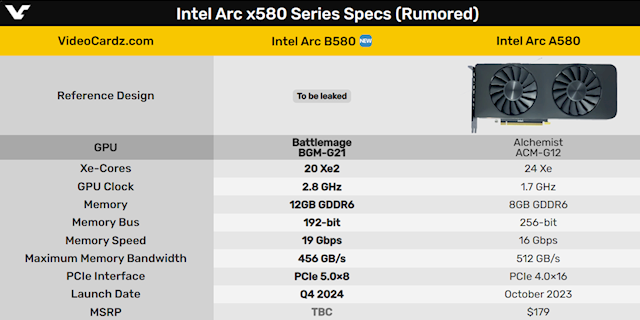

Intel锐炫B580独显曝光,规格提升与性能优化并存

Intel的二代锐炫显卡Arc B580近日在Geekbench平台现身,透露出多个重要的硬件规格和性能表现。主要特点如下:

核心与频率:Arc B580配备20个Xe²核心,等同于160个计算单元(CU),主频高达2.85 GHz,较一代锐炫A580的1.7 GHz大幅提升,提供更强的计算能力。

显存与带宽:Arc B580搭载12GB GDDR6显存,显存位宽从256-bit缩减至192-bit,但显存频率提升至19 Gbps,带宽为456 GB/s,相比A580的512 GB/s略低。显存容量的增加弥补了带宽的损失,预计不会显著影响性能。

OpenCL测试成绩:在Geekbench的OpenCL测试中,Arc B580获得78,743分,虽然不及传闻中的A580(A580为24个Xe核心,1.7 GHz主频,8GB显存,256-bit位宽,512 GB/s带宽),但不能完全反映游戏或图形处理的实际表现,仍需更多实际应用测试来验证。

能效与优化:虽然B580在显存和带宽方面略逊于A580,但其频率和显存容量的提升,加上位宽的减少有助于降低能耗、提高能效和减小芯片面积。

系统兼容性:Arc B580支持PCIe 5.0 x8接口,总带宽与PCIe 4.0 x16接口相当,同时为主板和SSD提供更多的PCIe 5.0通道,特别是在高端Z890、X870主板上的兼容性表现更好。

总结:虽然B580在某些规格上不如A580强大,但通过更高的核心频率、显存容量和系统优化,其整体性能表现令人期待。Intel在显卡领域的持续投入,可能将为消费者带来更多竞争力十足的产品,尤其在高性能显卡市场中,B580仍具备强大的潜力。

RTX 50系列显卡显存揭秘――桌面独宠三星GDDR7,笔记本多厂竞逐

NVIDIA即将发布的RTX 50系列显卡将在显存上迎来重大升级,桌面版显卡将全线采用三星的GDDR7显存,而笔记本版则将采用三星、SK海力士和美光的GDDR7显存,以满足不同市场需求。

在桌面端,NVIDIA选择三星GDDR7显存,显示出对三星技术的高度信任。尽管三星在桌面显卡上占主导地位,但在移动端,NVIDIA将灵活地使用三家厂商的显存资源,三星依然是主要供应商,SK海力士和美光也将参与其中,提供多样化选择。

关于GDDR7的频率,业界普遍认为RTX 50系列显卡的频率将达到28Gbps,甚至有观点预测未来可能高达32Gbps。这一提升将显著增强显卡性能。同时,三星也在研发更高频率的GDDR7显存,计划推出最高可达40Gbps的版本,尽管RTX 50系列未能及时采用,但这一技术进步为未来显卡性能的进一步提升奠定了基础。

总体来看,NVIDIA的显存选择与技术升级不仅提升了RTX 50系列的性能,也为未来显卡市场注入了更多的竞争动力。

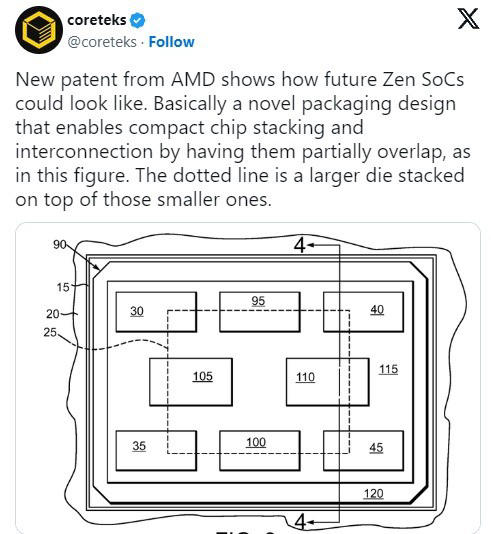

AMD新专利揭示多芯片堆叠技术,性能与效率双提升

AMD最近提交了一项新专利,展示了未来可能采用的“多芯片堆叠”技术。这项创新将通过将多个小芯片重叠堆叠,从而减少芯片间的物理距离,显著降低互连延迟,提高不同芯片部分之间的通信速度。

该技术不仅能在相同尺寸下实现更多核心、更大的缓存和更高的内存带宽,还能有效优化电源管理。通过对每个小芯片进行电源门控控制,系统能更精细地管理功耗,从而提高整体效率。

总体来说,这种堆叠设计将在提升性能的同时,还能改善热管理与能效,进一步推动AMD在游戏CPU市场的竞争力。

AI PC生态发展:摩尔定律与端侧AI模型的交汇

英特尔AI PC的崛起

2024年英特尔生态大会上,AI PC成为主角。英特尔在AI处理器市场的份额已达43%,AI PC处理器营收较去年增长了六倍,展现出AI PC快速崛起的强大势头。端侧AI算力的飞跃

英特尔通过酷睿Ultra系列处理器推动AI算力大幅提升。Lunar Lake芯片已实现120TOPS的AI算力,而未来的Panther Lake将进一步打破极限,为AI应用提供更强支持。随着AI算力的提升,端侧设备不再依赖云端,越来越多的智能功能可以在本地完成。端侧大模型的突破

AI大模型的端侧部署成为焦点,面壁智能通过MiniCPM 3.0在Lunar Lake处理器上实现了167%的AI加速,推理延迟降低17%。这一突破意味着,即便在资源有限的端侧设备上,也能实现类似GPT-3.5的强大推理能力,真正让生成式AI走向普及。AI应用的实际落地

AI PC不仅停留在算力和工具链的提升,更加速了实际应用的落地。从金融分析到游戏训练,端侧AI应用正变得越来越实用。同花顺的AI PC版帮助投资者通过自然语言生成股票分析代码,提升交易决策效率;《无畏契约》的AI教练则为玩家提供实时技能指导,改写了竞技游戏的训练方式。英特尔的未来战略

英特尔计划通过打造高效能XPU算力平台,构建丰富的软件生态,推动AI PC的普及。未来,AI PC将不仅仅是硬件平台的更新换代,更是整个PC行业生态的大步跃升,带来更多创新应用与市场机遇。

总结

AI PC正在快速改变计算和应用的方式。凭借更强的端侧算力、更高效的AI模型以及更实用的应用场景,AI PC正在成为行业的“新风口”,推动PC行业进入智能化、自动化的新时代。

台积电1.6纳米芯片突破:背面供电技术引领未来

A16工艺亮相

台积电计划2026年底量产1.6纳米(A16)芯片,采用创新的背面供电技术(SPR),推动芯片微缩并提升性能。背面供电技术

A16芯片将电源轨移至芯片背面,减少电源和信号线干扰,提升逻辑密度,性能比上一代提升8%-10%,功耗降低15%-20%。技术挑战与合作

背面供电面临散热和制造难题,台积电与新思科技、ANSYS等合作,利用AI加速设计解决这些问题。未来应用

A16工艺预计将应用于未来几代苹果芯片,提升高性能计算能力。

总结

台积电的A16芯片通过背面供电技术实现了性能和功耗的突破,虽面临挑战,但未来应用前景广阔。

探索更多,携手共赢

如有任何问题、反馈或合作意向,请直接点击下方按钮。我们期待与您建立联系,共创美好未来。