4路32核64线程 顶级Nehalem-EX平台评测(上篇)

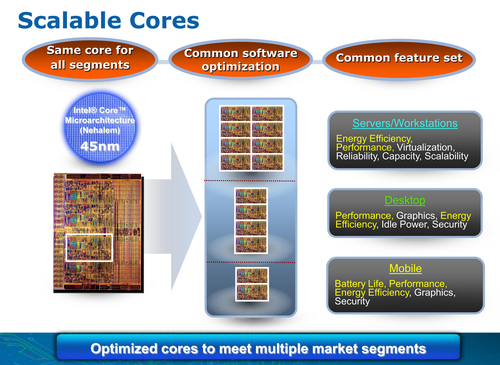

Nehalem:单一、可扩展的核心设计面向所有的产品线

最早在2008年发布的Nehalem处理器架构研发开始于2003年(对其的研究更早就开始了)。Nehalem是Intel的第一个真正的Converged Core(融合核心)设计产品,也就是说,同一个核心面向所有的产品线,从移动、桌面,到工作站和服务器,都基于同样的内核设计。这样,它们就可以享用通用的软件优化,开发和维护也变得方便了。融合核心的思想最终导致了Nehalem变成了现在这个样子:Core和Uncore分离的模块化设计、多核心带超线程、内置内存控制器的直联架构、PCU功率控制单元以及Turbo Mode睿频加速技术等等,Nehalem是一个既注重性能表现又注重功耗表现的平衡、具有良好伸缩性的优美设计。

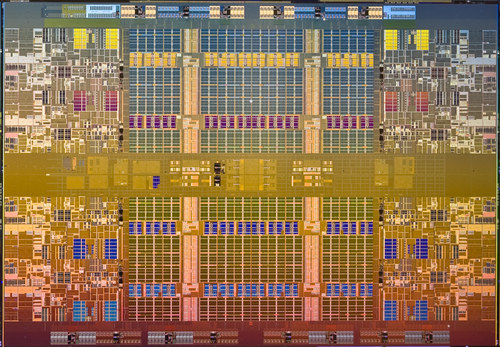

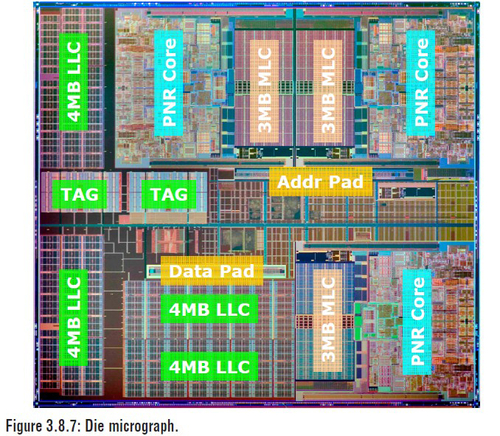

45nm八核心:Nehalem-EX晶圆图

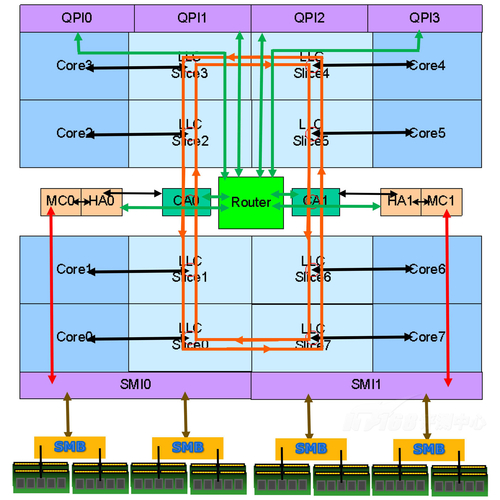

对称美:Nehalem-EX的架构图(附带内存子系统)

得益于这样的模块化设计,Nehalem架构当中出现了于Nehalem-EX这样的面向多路服务器市场的八核心产品,不过,为了在多核心下也能获得良好的性能,并且要提供符合其定位的关键RAS(Reliability, Availability, Serviceability:可靠性、可用性、稳定性)特性,Nehalem-EX对Uncore结构进行了重新的设计,这样让其与最早的Nehalem微架构发布隔了相当久的时间。最早出现的Nehalem架构处理器是桌面的Core i7,2008年8月发布,服务器版本Nehalem-EP则是在2009年3月底发布,而Nehalem-EX则是今年的3月底发布。毫无疑问,改进的Nehalem-EX是Nehalem架构中的巅峰产品,拥有着强大的性能以及同样强大的身价。

照例,Intel也给我们提供了Nehalem-EX的测试样品,不过,由于测试样机需要从山远水远的美国运来,并且这个测试样机体积和重量以及报价都比较“特别”的缘故,因此,直到6月多的时候,笔者才拿到了这台机器(海关真是麻烦,两边都是):

Intel Nehalem-EX官方测试样机:外表不凡,内里更是不凡!

这台测试样机由Intel和Quanta合作打造的QSSC-S4R服务器样机配置了四个Xeon X7560处理器,是Nehalem-EX产品线中最高端也是最贵的型号(千颗单价3838美元),每个处理器具有8个核心,整个服务器就是32个物理核心、64个线程;样机还搭配了一共256GB的R-ECC DDR3-1066内存以及两个代号为Boxboro-EX的IOH芯片,顺便还搭载了一块OEM LSI的Intel阵列卡(原始型号是9260-8i)以及两块64GB的X25-E企业级SSD,配置十分豪华(这块SAS 6Gb/s阵列卡已经是其中最便宜的组件了)。下面我们就来领略这台怪兽的性能,不过首先我们要先再次温习这个平台的架构。关于Nehalem-EX仍有一些容易误解的地方,为了澄清这些误会,笔者进行了大量的工作。

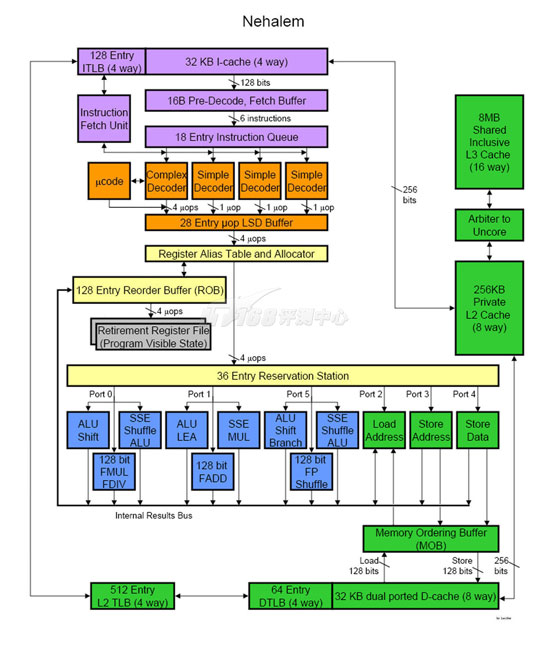

Nehalem Microarchitecture

既然顶着Nehalem的大名,Nehalem-EX自然也是基于Nehalem微架构。前面说过,设计上Nehalem就考虑到了这种情况,它采用了一种“模块化”的设计方案,系统分成了Core和Uncore两个大模块,每个模块再分成多个小的模块,这样通过不同的组合,就可以衍生出不同核心数量、不同L3缓存等处理器产品。实际上,Nehalem-EX架构和通常Nehalem相比最大的不同就在Uncore架构上。

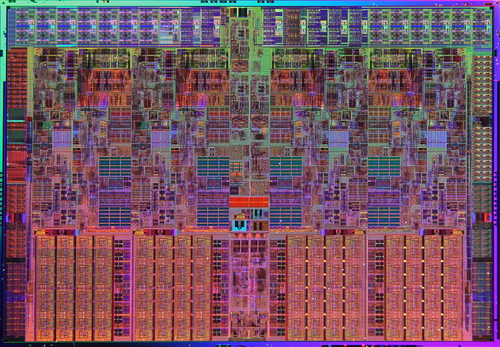

Dunnington??Nehalem-EX的上一代??的晶圆构造图

Nehalem-EP晶圆图

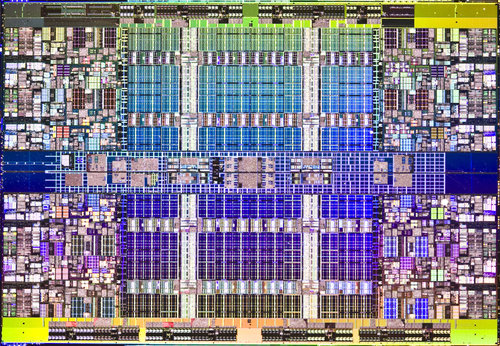

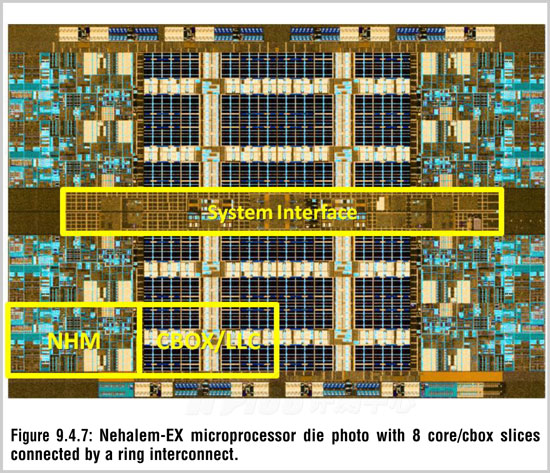

Nehalem-EX晶圆图

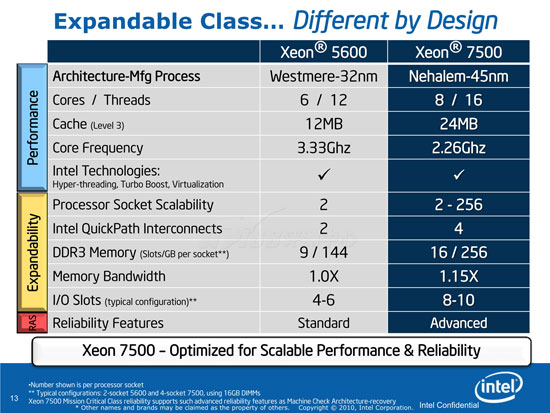

我们首先要清楚企业级Nehalem处理器的后缀:计有Nehalem-EN、Nehalem-EP、Nehalem-EX。其中,EN是指Entry(入门)、EP是指Efficient Performance(效率、性能)、EX是Expable(可扩展)。Nehalem-EN就是常见的单路Xeon 3400系列,Nehalem-EP则是双路Xeon 5500系列,而Nehalem-EX就是多路Xeon 7500系列了。Nehalem-EX就相当于之前的Xeon MP系列,它可以组建四路或者四路以上的多路处理器系统。比较少人知道的是,Nehalem-EX也有面向双路的产品:Xeon 6500系列,用来满足一些地方不需要大量的计算能力但是需要足够的稳定性以及大容量的内存支持能力。

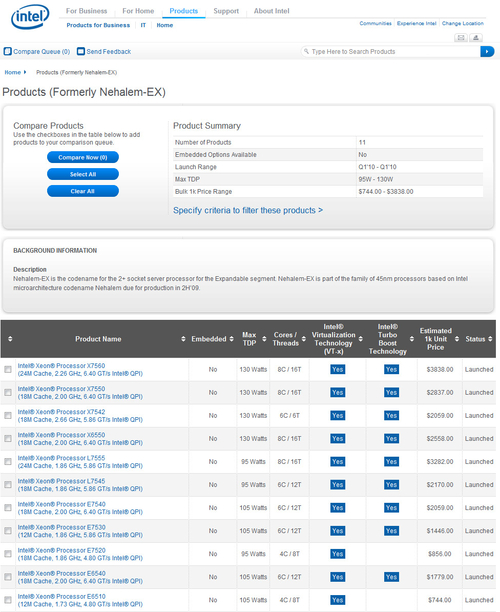

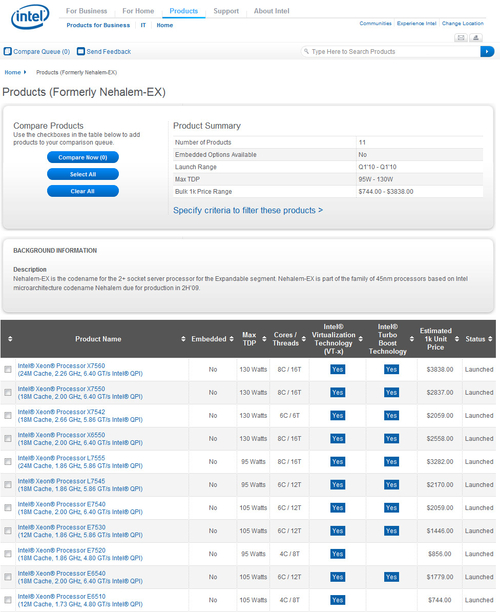

Nehalem-EX家族11个产品的简介

最高端的Xeon X7560具有8个核心和24MB的L3缓存,频率2.26GHz,千颗单价3838美元;最低端的Xeon E6510,4个核心和12MB L3缓存,频率1.73GHz,千颗单价只有744美元,只能组建双路系统。

接下来我们就来看看Nehalem-EX的内部架构。

由于Nehalem家族的微架构都一样,因此笔者不再介绍微架构,关于这部分的内容,可以看这里:

Intel Nehalem-EP处理器首发深度评测

我们从Nehalem-EX的Uncore架构说起,它是和其他Nehalem处理器区别开的地方。Uncore首先包括了所有核心共享的L3缓存部分:

Nehalem-EX处理器晶圆图,中央大片区域都属于L3缓存

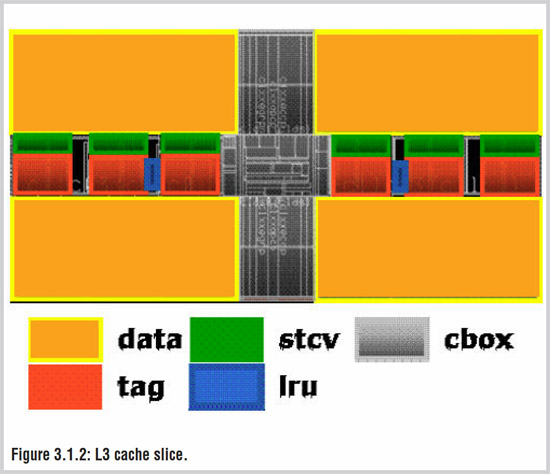

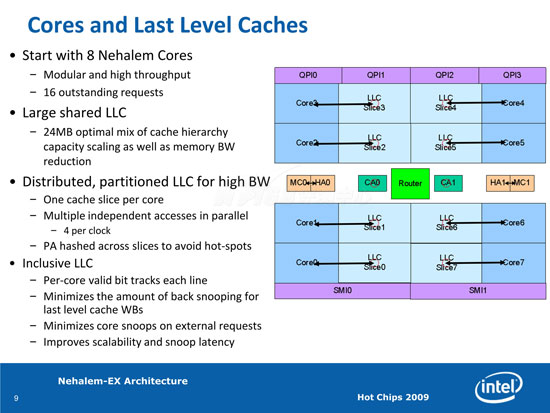

Intel的服务器处理器都具有巨大容量的缓存,但是Nehalem-EX的更大一些,8个核心共享一共24MB L3缓存,并且它们分成了8片(Slice),每片有2048组以及24路集合关联,缓存线为64个字节。每个Slice分成48个子阵列,如下图这样:每一个访问只有整体阵列的3.125%加电,从而降低了耗电量。数据阵列使用0.3816um2的单元并使用DECTED(Inline double-error correction triple-error-detection,双位纠错三位检测)ECC进行保护,具有可变的访问延迟;Tag索引阵列则使用了0.54um2的单元并使用SECDED(Inline single-error-correction double-error detection,单位纠错双位检测)ECC进行保护,并具有固定的访问延迟。数据阵列具有行冗余和列冗余,Tag阵列则只有列冗余,这些冗余用于在一些阵列单元有缺陷或者损坏的时候担当备份,并通过一个EEPROM控制L3缓存冗余熔断器进行设置,有些类似于硬盘通过P-list和G-list保存扇区重定位到冗余扇区的列表一样。

L3缓存Slice结构

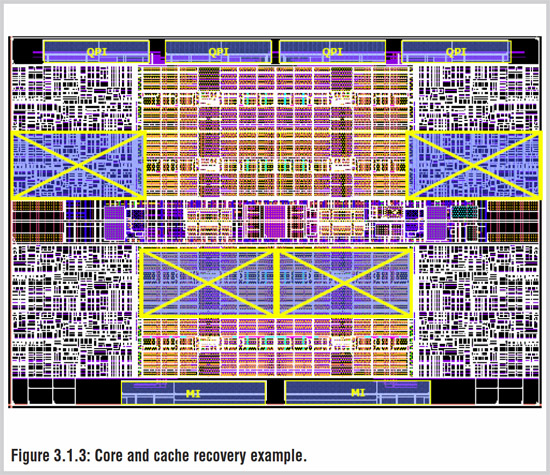

对于这些冗余技术,Intel特别称为Core--cache Recovery核心及缓存恢复,出现小缺陷或者小问题的缓存和处理器核心电路都可以通过冗余线路继续工作,当大量缺陷存在或者大量问题出现的时候,对应的核心和缓存可以设置为关闭模式以降低耗电。彻底避免这些线路用电是不太可能的,在关闭模式下,SRAM的供电将从0.90V降低到0.36V,提供83%的漏电功耗节约,作为比较,睡眠电压是0.75V,节约为35%。大量缺陷在出厂之前会被检测到,由于宇宙射线或诸如此类的因素导致的损坏则可能在工作时被检测到,最后8核心的Nehalem-EX可能会变成一个6核心甚至4核心的Nehalem。如下图所示:

Core cache recovery

每个核心都有对应的一块L3缓存,可以并行进行存取,效率比起通常的Nehalem要高不少

Nehalem-EX的每个核心可以分到3MB,比Nehalem-EP/Westmere-EP的2MB要更大一些。这8个3MB的Slice(块),每一个L3块在每一个时钟周期可以同时进行4个存取操作,这样Nehalem-EX在同一个时钟周期就可以同时进行32个L3缓存操作。并且,L3缓存对应的物理地址通过哈希计算分布到多个L3 Slice上,从而将存取操作分散,避免了热区效应(hot-spot)。在通常的处理器中,共享的LLC缓存只会有一个端口,同时只能进行数个操作。

在核心数量逐渐提升的情况下,处理器对存储的压力也越来越大,特别是带超线程的Nehalem-EX,将会有16个硬件线程同时存取共享的L3,以及内存。使用通常的Crossbar交叉开关总线的话,不同硬件线程存取操作的冲突会比较明显,这会增加存取的延迟,影响系统的工作效率(这也是Xeon版Nehalem的Uncore工作频率要比桌面版Core i7要高的缘故),并且在核心数量越来越多的情况下,使用交叉开关将会变得非常昂贵(开关的数量以平方数增长)。增加通常的Uncore工作频率对此有一定效果,不过Uncore频率也不是可以无限制地提升的,在架构上解决这个问题是最好的是:使用其他的总线架构。

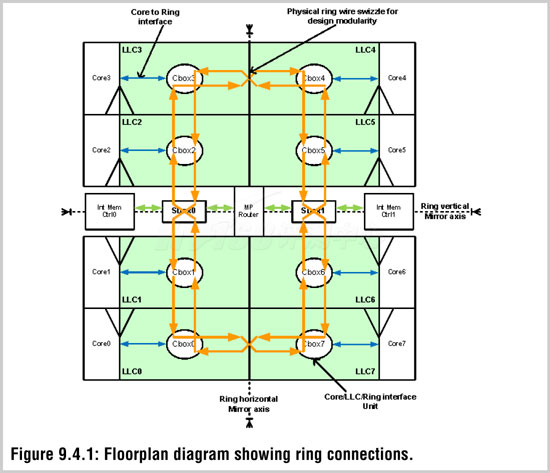

Nehalem-EX:Ring Interconnet

ISSCC 2010:Nehalem-EX的环状总线架构

Nehalem-EX多个核心/L3块之间的互联通过一个环形总线来完成,而通常的Nehalem处理器则是通过传统的Crossbar来进行,在Intel 32nm Westmere-EP处理器首发评测中我们对Westmere-EP进行的测试结果表明, 六核Westmere-EP比四核Nehalem-EP的L3缓存内存潜伏期有所上升,内存带宽也下降了,这表现了传统架构在核心数量变多、访问冲突增加之后的效应。要想达到8个或者更多的核心数量,最好是:使用其他的总线架构,就像Nehalem-EX这样。

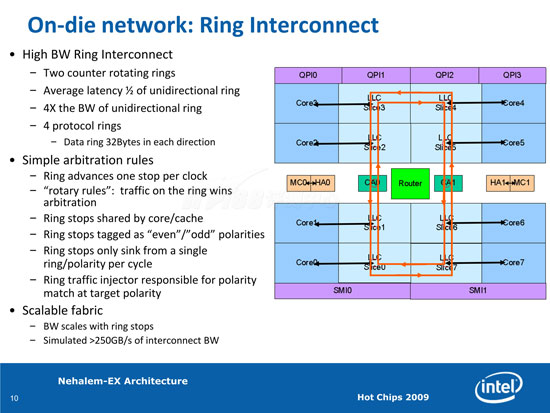

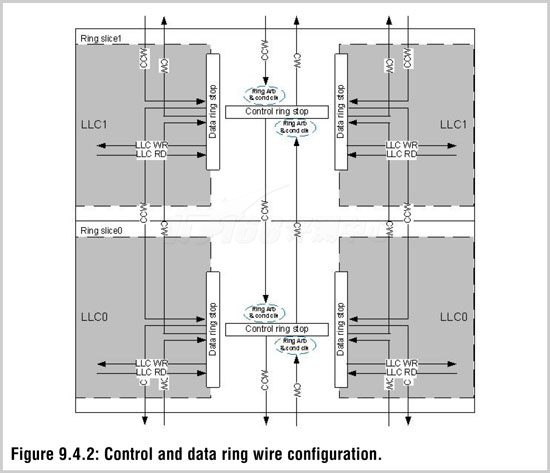

片内网络:环形互联

新的总线架构同时改变了Nehalem-EX的L3架构,在传统Nehalem上,CPU核心通过交叉开关来连接L3,但是Nehalem-EX上,这个交叉开关变成了一个环状总线,而同时L3缓存块和CPU核心的连接也更加紧密,通过bypass结构,可以实现0延迟的访问L3(当然,是指Core - L3无延迟)。Nehalem-EX的环状总线由十个节点(Ring Stop)组成,其中8个是连接到Core/L3 Cache的节点,叫做Cbox,还有两个是Sbox,用来连接内存控制器和外部的QPI总线,这个环状总线是双向的,运行在Uncore频率,数据从一个节点传输到邻近节点只需要一个Uncore时钟周期,总带宽可以达到1.2TB(0.8TB/s数据信号,0.4TB/s控制信号)。环状总线的优点是到不同区域具有预知的、恒定的延迟,到达最远的节点只需要5个时钟周期。

在设计上,Nehalem-EX晶圆基本上是有水平和垂直两条对称轴的,这样可以降低布线的复杂程度

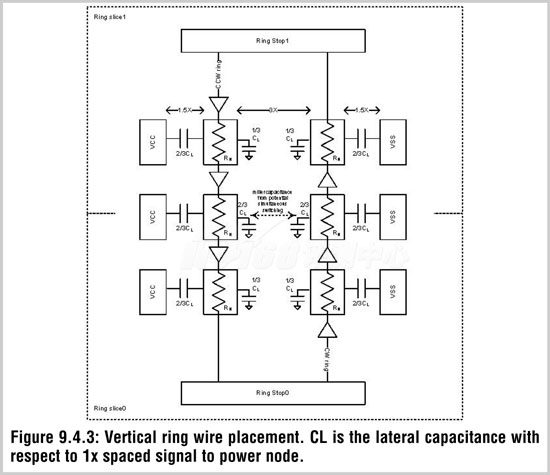

和QPI一样,Nehalem-EX的环状总线并不是一个串行总线,它们是并行的,在每一个环站上,大约有近1000个信号在传输,峰值信号带宽可以达到3TB/s,1.2TB/s属于持续的带宽。

处在M7层的纵向信号线具有较低的电容值以提升传输速率,这些信号线具有1.5倍的宽度,两个环的间距是通常布线的3倍,与地线的距离也是通常的1.5倍

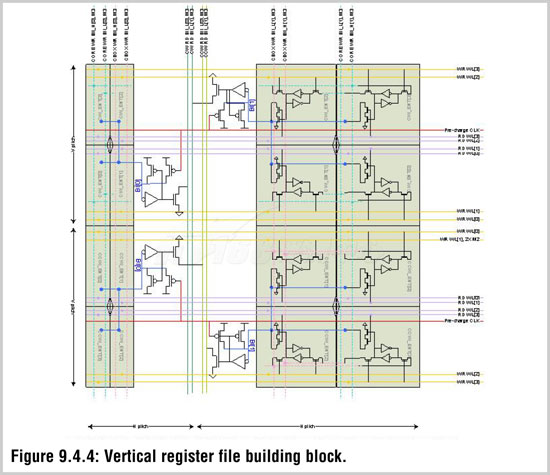

纵向数据通道使用的双端口寄存器文件允许同时对CPU核心和L3 Cache的写入操作

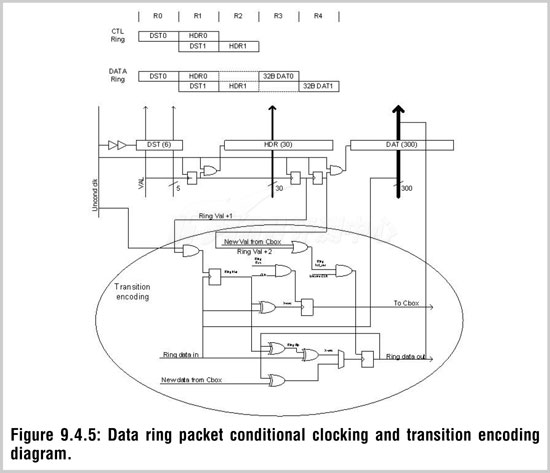

为了降低功耗,数据环使用了Clock Gating技术,只有传输数据的时候才有时钟产生,这可以大为降低总线的闲置功耗

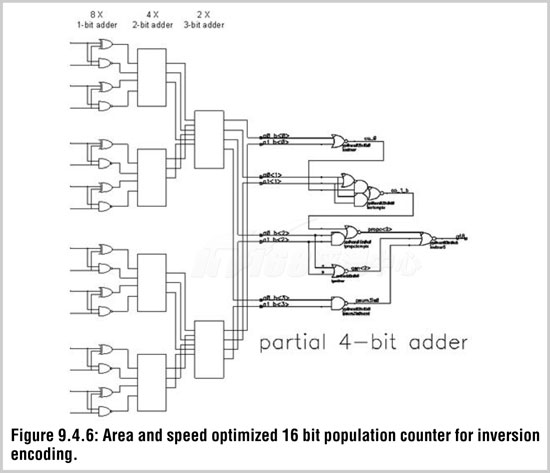

为了弥补Clock Gating只能在闲置时生效的缺点,Nehalem-EX还使用编码解码技术,可以在大中负荷下具有适中的能耗节约

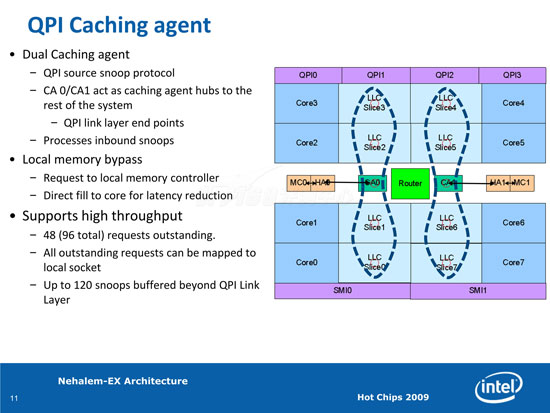

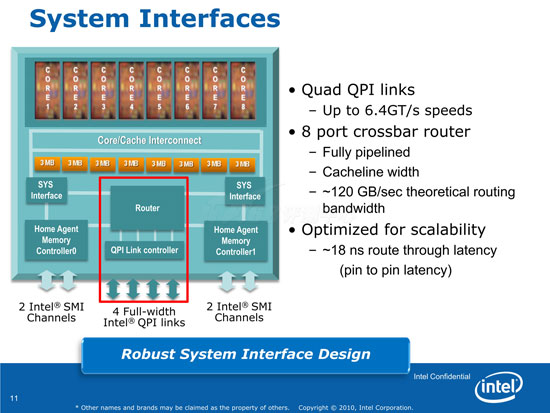

在环形总线上,除去8个Core/L3缓存站之外,剩下的两个站就身负对外部进行IO的重大任务,名字上,它们叫做QPI Caching agent,除了负责连接外部的QPI总线之外,它们也负责连接系统的内存控制器:

QPI Caching agent,每个使用QPI的处理器都有

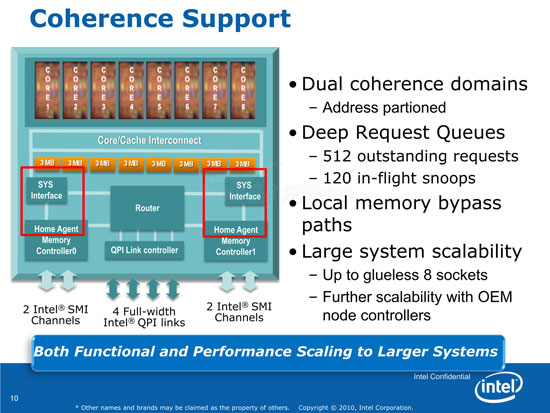

QPI Cachingagent??CA0/CA1通过连接Router模块来连接外部QPI总线,通过连接HA0/HA1模块来连接内存控制器,它支持48(两个CA合96)个并发请求,并支持120项的snoops buffer。

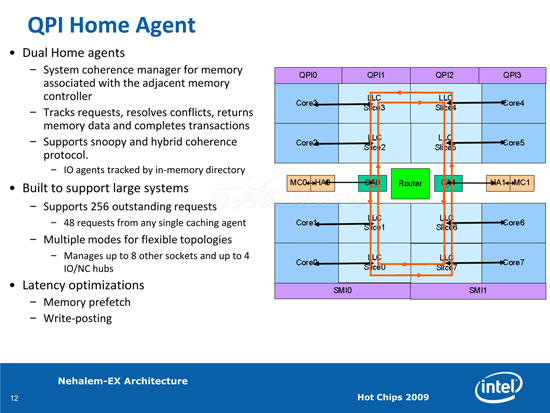

QPI Home Agent ??HA0/HA1则负责沟通QPI和内存,它支持256个并发请求(每个Caching agent支持最多48个并发请求),并且支持来自8个其他处理器、4个其他IO/NC芯片的请求。两个HA一共能支持512个并发请求。QPI HA还使用了内存预取、预写入等优化延迟的技术。

两个一致性分区,每个区含一个内存控制器,不同的区将地址空间分割

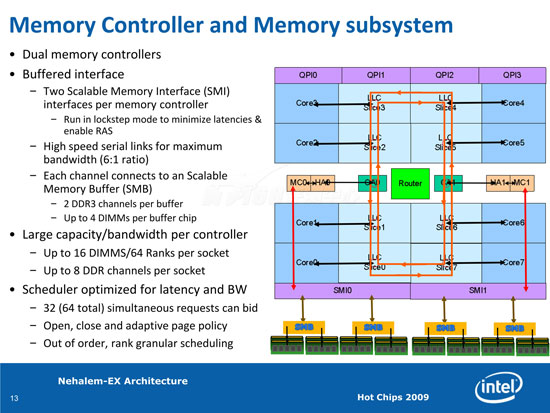

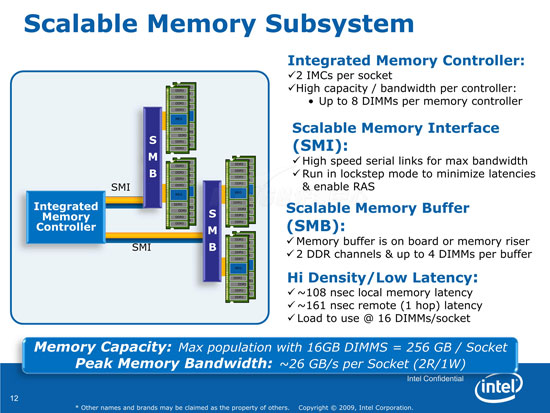

内存子系统部分是Nehalem-EX中误会较多的地方。Nehalem-EX的HA0/HA1分别连接到MC0/MC1,一共两个内存控制器,普通的Nehalem处理器只有一个内存控制器。每个内存控制器提供一个SMI(Scalable Memory Interface),每个SMI界面提供了两个SMI Link,又称SMI Channel,它们可以运行于Lockstep模式(普通的Nehalem处理器也提供了这种模式)以提升性能和增强RAS。每个Nehalem-EX就提供了4个SMI Link。注意SMI Link和SMI本身的区别。

SMI Link看起来并不是一个串行界面(笔者之前的做法看起来并不正确)。SMI Link各方面和QPI Link都很像,例如它的传输速率是6.4GT/s,从这点来看它也不应该是串行总线,QPI也不是串行总线。然而,SMI Links的带宽还是个谜,因为它的位宽并不清楚,Intel没有公布这个数据。

Nehalem-EX:2MC/2SMI、4SMI Link/4SMB、8 Memory Channel、16 DIMM、256GB

SMI Link需要连接到一个叫做Scalable Memory Buffer(SMB)的芯片才能联接到并行的DIMM上(久远的Pentium 4使用的RIMM则本身是串行的),因此这让人联想到SMI是串行的,不过从其6.4GT/s的速率来看,不太像。SMB这个名字听起来和以前FBD内存上的AMB芯片很相似,AMB用来将内存管理器的串行界面转换为内存条的并行界面。在Nehalem-EX上,这个SMB可以集成在主板上而不是集成在内存条上,兼容性远非FBD架构可比。用于Nehalem-EX平台的SMB芯片还有一个开发代号(Code Name),叫做Mill Brook 1。

每个SMI Link支持两个SMB芯片,每个SMB芯片支持两个DDR3内存通道,每个内存通道最多支持2个DIMM,这样一个Nehalem-EX处理器就能提供最多8个内存通道、16个DIMM、256GB的内存容量支持。Nehalem-EX特别的地方是支持16GB的单条内存,其它Nehalem处理器只能支持8GB单条内存。Westmere-EP支持单条16GB内存。Nehalem-EX支持8个内存通道,这确实和通常想象的不太一样。很多人曾以为它支持的是4个内存通道。

目前,Nehalem-EX只支持R-ECC DDR3 1066规格,这会限制其内存带宽。Intel表示其未来可以支持到R-ECC DDR3 1333规格(和通常的Nehalem-EP不同,Nehalem-EX不支持普通的不带R、ECC的内存)。

这个图的数据应该没有什么问题,除了最底部的那个

上图上,本地内存访问延迟约是108ns,距离一跳的远程内存访问延迟约是161ns,比使用DDR3 1333的Nehalem-EP/Westmere-EP要高,即使是Nehalem-EX以后达到DDR3 1333的规格下也应该差不多。这是使用了SMI和SMB的代价,作为交换,Nehalem-EX获得了增强的内存RAS特性,以及更高的带宽和更大的容量支持。

如表所示,Nehalem-EX的内存带宽只是Westmere-EP的1.15倍么?

从本页的第二幅图的数字来看,每个处理器的峰值内存带宽是约26GB/s,每个内存控制器的带宽是13GB/s(或许准确的是12.8GB/s?),理论上,8个DDR3-1066通道提供的带宽应该是66.7GB/s,理论和现实总是有一些距离,或许原因出在SMI Link上。在IDF2009给出的文档上,26GB/s这个数字被换成了50GB/s。

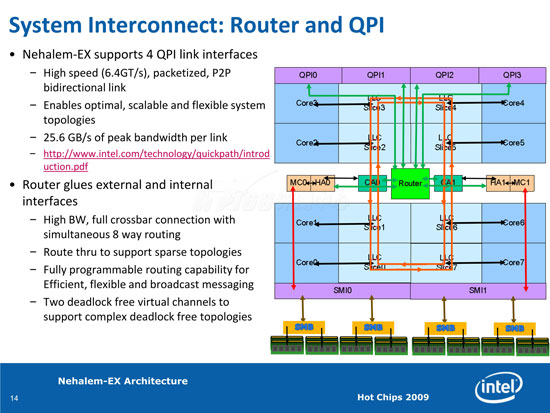

作为Intel直联架构的一个重要部分,QPI总线在多路系统总扮演着非常重要的角色。在Nehalem-EX当中,4个QPI总线通过一个Router模块和内部环形总线以及内存控制器连接起来。实际上,CA0/CA1、HA0/HA1以及Router这三个模块都是可以直接互相通信的。

Router模块面对着8个组件:两个CA、两个HA,以及四个QPI,它是一个8端口的Crossbar交叉总线架构,任意两个组件之间可以建立直接的通信通道。这个交叉总线为全流水线设计,宽度为64bit(缓存线宽度),可以提供约120GB/s的理论交换带宽,路由延迟约为18ns。Nehalem-EX的Router模块还支持两个无死锁虚拟通道,以支持复杂的无死锁拓扑结构。

四个QPI总线,每个3.2GHz、6.4GT/s,双向带宽25.6GB/s

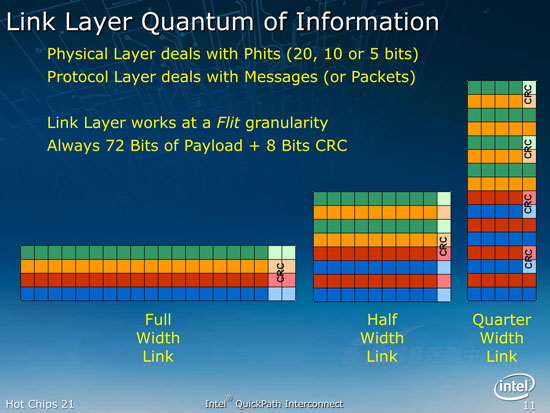

可能和很多人想的不一样,QPI是一个并行总线而不是一个串行总线,和HT总线一样,它可以拆分为半宽度的链接;QPI可以分为四分之一链接,这一点比HT要特别一些

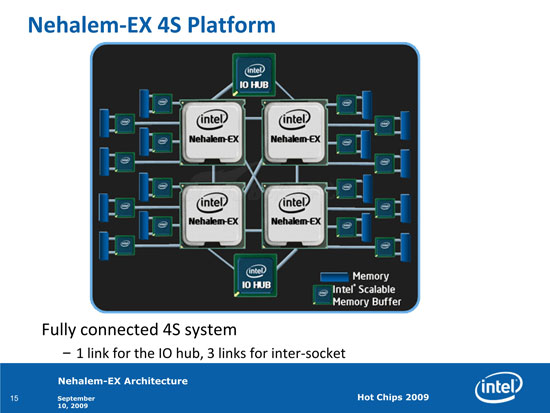

4路Nehalem-EX,可以连接两个IO Hub

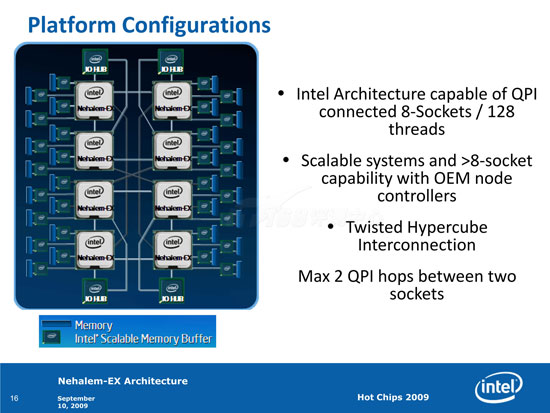

8路Glueless架构的Nehalem-EX,任意处理器之间最多两跳距离

QPI通过Node Controller,还可以支持更多路的结构

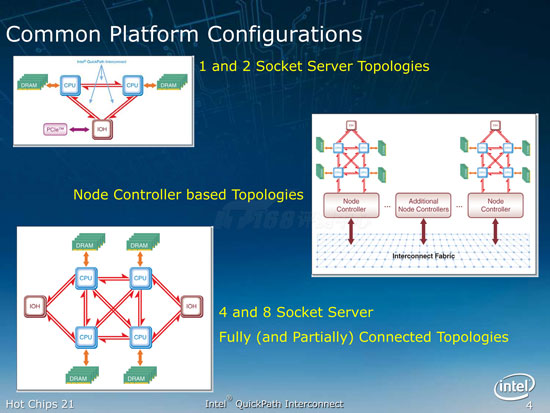

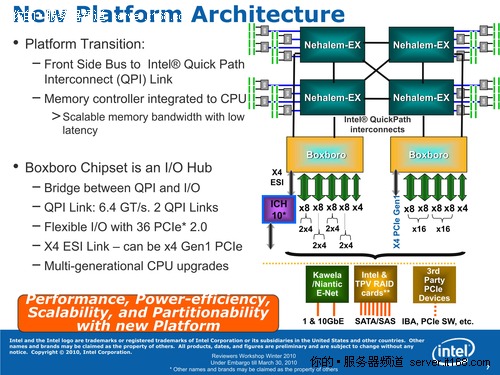

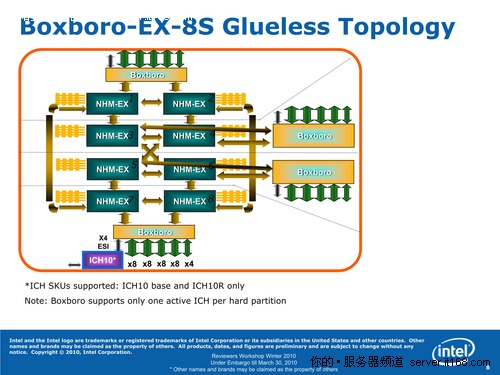

看完处理器,我们接下来看看处理器需要搭配的主板芯片组,Nehalem-EX搭配的主板芯片组代号叫做Boxboro,也可以叫做Boxboro-EX,类似于双路端的Tylersburg-EP芯片组(桌面的就叫Tylersburg):

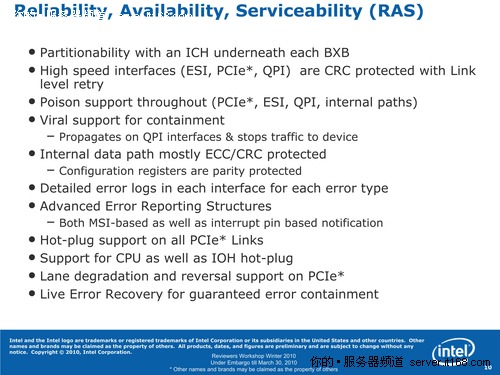

只是,由于Nehalem-EX是多路设计,因此对应的Boxboro芯片往往有多个,基本上,两个Nehalem-EX处理器就需要搭配一个Boxboro芯片,每个芯片属于一个Partition分区。当然,连接键盘鼠标的ICH芯片整个系统只能有一个:

八路Nehalem-EX需要四个Boxboro芯片,不过只能使用一个ICH10R

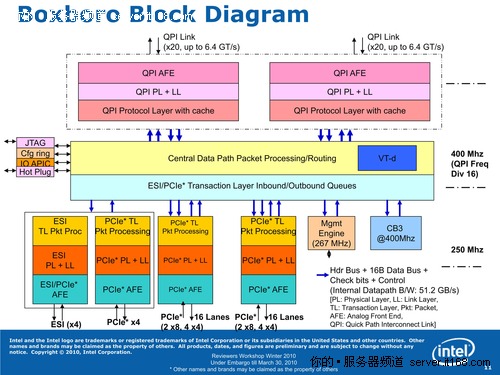

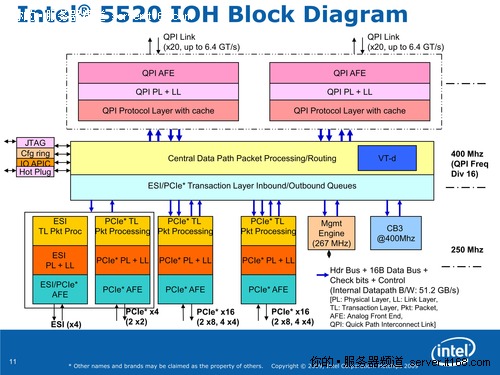

看到Boxboro我们将会感到非常熟悉,实际上,它和Tylersburg芯片非常相似,从架构图上看起来就是一样,只是改了个标题:

Boxboro:7500芯片

Tylersburg:5520芯片

它们的区别应该是在IOH的RAS特性上,这一点后面再谈。Boxboro/Tylersburg家族的IOH每个都提供了最多36 Lanes的PCI Express 2.0接口,提供充足的IO带宽(实际测试大约是14GB/s每IOH),并且还可以搭配多个IOH。其实,二路的Nehalem-EP也有一个双IOH配置,提供72 Lanes的PCI Express 2.0。南桥芯片ICH10/10R还提供了6个Lanes的PCI Express 1.01a接口,不过通常用来接显卡和KVM,用来接服务器使用的高速IO设备比较勉强。

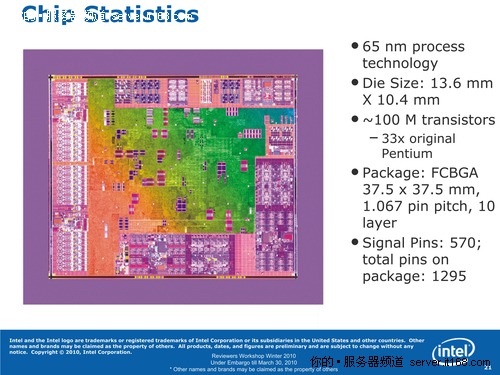

Boxboro:65nm工艺,约1亿晶体管

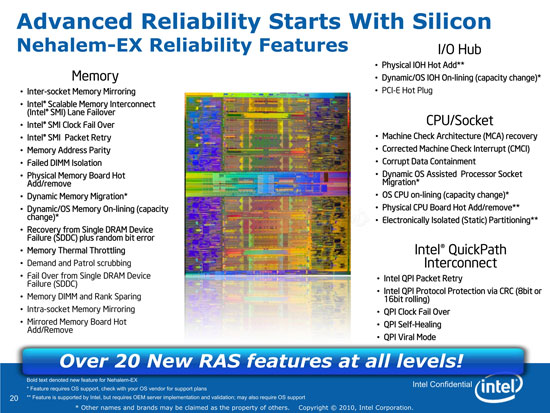

在前面,笔者分析了Nehalem-EX处理器内部架构相对于通常的Nehalem处理器的不同,此外,Nehalem-EX和通常的x86处理器很不同的一个地方是,它面向Mission Critical(关键任务)市场,相对于性能,这些市场上更加重要的是平台的可靠性。Nehalem-EX增加了相当多的RAS(Reliability, Availability, Serviceability:可靠性、可用性、稳定性)特性来满足关键任务计算的需求:

简单来说,RAS大约体现了系统的健壮性;Intel的安腾平台就带有很多RAS特性

传统的x86处理器难以进入关键领域的原因,就在于其RAS特性不足,可靠性不够,用户不敢在上面跑相关应用。Nehalem-EX的出现,将x86系统的可靠性带到了一个全新的水平,如图上所示,这些RAS特性非常多,大致总结如下:

|

Nehalem-EX RAS Features | ||||||

| 类别 | 功能 | 特性 | 说明 | |||

| 数据保护 | 降低关键级别错误 全系统数据错误检测 限制错误所致影响 |

Parity checking ECC 奇偶校验与ECC |

||||

| Memory Themal Throttling 内存热量监控 |

防止内存过热 | |||||

| Memory dem & patrol scrubbing 内存按需/轮询检查 |

提高全系统数据可靠性 | |||||

| Corrupt data containment 污染数据隔离 |

限制错误数据造成的影响 | |||||

| QPI viral mode QPI病毒模式 |

标记为Viral的数据包将被限制在QPI总线内而不会发送到设备上 | |||||

| QPI rolling CRC QPI持续CRC校验 |

QPI CRC校验扩展到两个连续的包 | |||||

| 高可用性 | 恢复失效数据链接 从失效部件迁移 从不可修正错误中恢复 故障预测 |

Intel SMI Lane Failover SMI内存接口信道容错 |

||||

| Intel SMI Clock Failover SMI内存接口时钟容错 |

||||||

| Intel SMI & QPI Packet Retry SMI & QPI包重发 |

||||||

| QPI Clock Failover QPI时钟容错 |

||||||

| QPI Self-Healing QPI自愈 |

||||||

| SDDC plus rom bit error recovery 内存SDDC纠错与任意位错误恢复 |

||||||

| Memory Mirroring 内存镜像 |

||||||

| Memory DIMM Rank Sparing 内存DIMM和Rank热备 |

||||||

| Dynamic CPU memory migration CPU/内存动态迁移 |

需要操作系统支持 | |||||

| MCA-recovery with OS support MCA恢复 |

需要操作系统支持 | |||||

| 计划宕机时间最小化 | 分区模块化 替换失效组件 |

Static System partitioning 静态系统分区 |

需要操作系统支持 | |||

| MCA error logging (CMCI) with OS predictive failure analysis 用于操作系统失效分析预测的MCA错误记录 |

||||||

| Physical Memory Board Hot Add/remove 物理内存卡热添加/热移除 |

||||||

| Dynamic/OS Memory On-lining(capacity change) 动态内存在线(容量变更) |

需要操作系统支持 | |||||

| Physical CPU Board Hot Add/remove 物理CPU卡热添加/热移除 |

需要操作系统支持 | |||||

| OS CPU on-lining(capacity change) 动态CPU在线(容量变更) |

需要操作系统支持 | |||||

在Intel正式宣传的文档中,提到的RAS特性就是上面22条,集中解决三个方面的问题:一是数据保护,利用CRC、ECC等硬件机制来对传输的数据进行校验、纠错,如果无法纠正,就将损坏的数据进行隔离,以保证不造成更大的数据,避免系统的重启和宕机。二是高可用性,包括各种主要部件的备、镜像和热切换等,以保证系统的高可用性。三是计划宕机时间最小化,包括系统分区管理技术、CPU和内存的热添加和热移除等,将系统维护时间降低到最小。

众多RAS特性通过CPU、芯片组的配合来达,首先,硬件通过Parity/ECC/CRC等手段尽量保障运行信号传输的正确性。

Boxboro的RAS特性

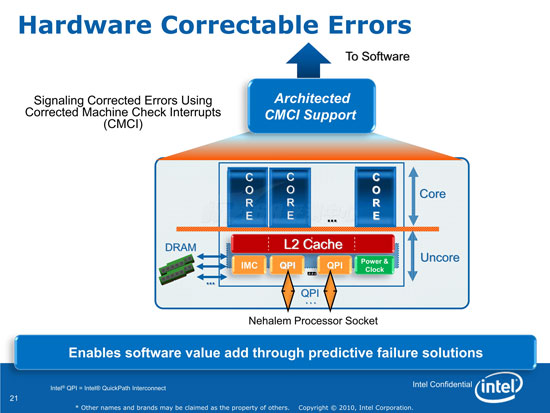

在硬件无法纠正所有错误的时候错,平台通过CMCI(Corrected Machine Check Interrupts)特性向软件报告,因为即使是硬件错误,也有些是可以接受的,例如,一些定时备份结果的计算只需要从最近的某一阶段重新开始计算即可,不需要因为某个硬件错误就程序崩溃,关键是软件需要知道这个错误的详细信息以进行判断:

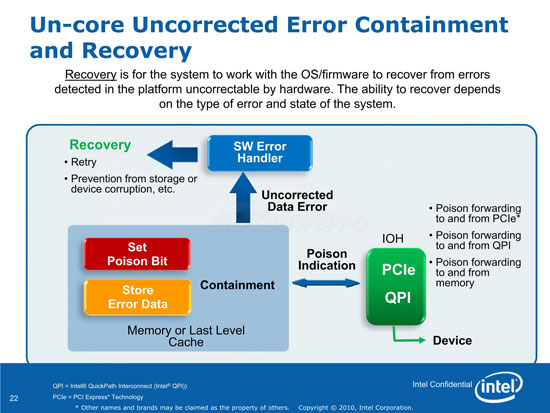

Nehalem-EX平台提供了一系列需要联合OS/firmware进行的错误隔离以及错误恢复:

对无法纠正的数据,使用一个Poison(毒药)标记,OS/firmware可以知道这些数据在硬件层次上无法恢复,从而可以决定进行Retry或者丢弃

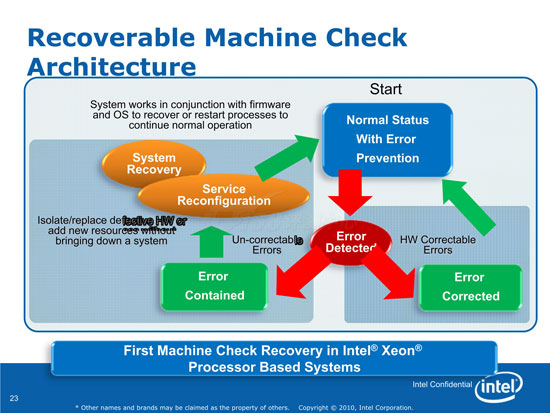

这些特性形成了一个完整的MCA架构(Machine Check Architecture):

Recoverable MCA系统可以在多个椭圆、方块表示的多个状态之间切换,并不会宕机

MCA是一个原来只在IA64架构处理器上才有的功能,MCA功能可以在不关机的情况下检查和纠正处理器、内存或者IO中的错误,在OS配合的情况可以对系统进行热维护,保障系统的不间断运行。据表示,包括微软Windows Server、RedHat、SUSELinux以及VMware等平台都已经支持这一功能。

Nehalem-EX家族11个产品的简介

目前,Nehalem-EX家族一共推出了11款产品,其中7500系列有8款,6500系列有3款。TDP分为95、105、130三个档次,照例用了L、E、X三个前缀,不过和TDP不是绝对的一一对应关系。8核心的Nehalem-EX一共有四款:X7560、X7550、X6550和L7555,四核心的有E7520和E6510,剩下的5款都是六核心的型号。

Nehalem-EX的频率普遍不高,最高的X7542也只达到了2.66GHz,然而其只有6个核心,并且QPI只有5.86GT/s。总体规格最高的是X7560,频率2.26GHz,8个核心,售价也是最高的:3838美元。我们收到的样机一共配置了四颗X7560。

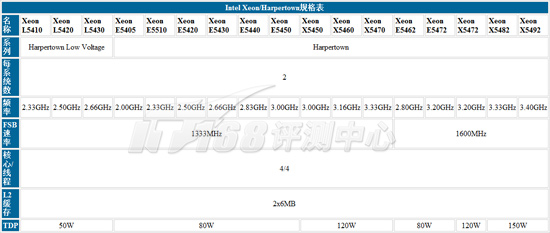

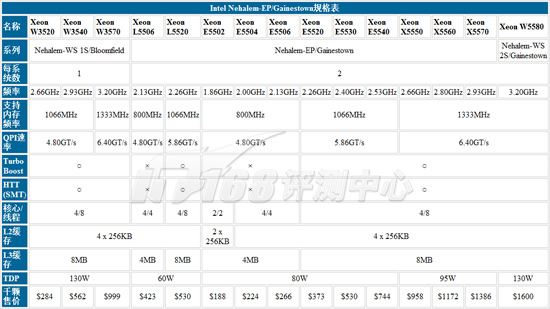

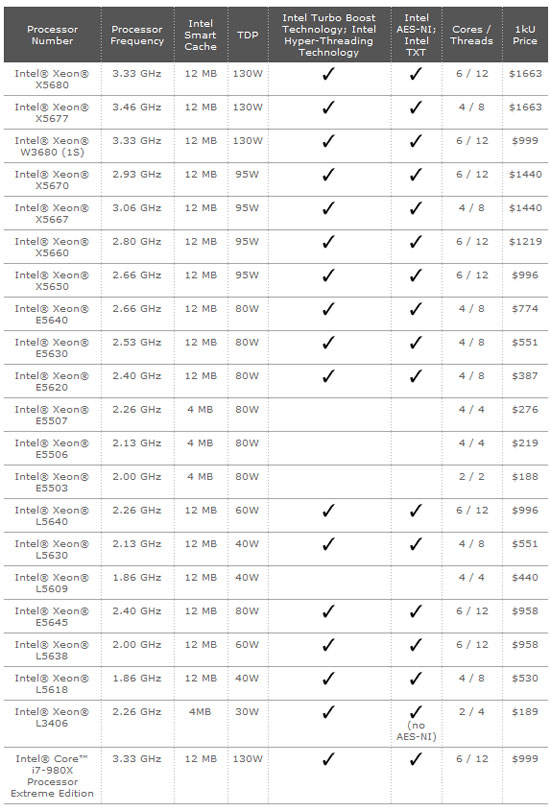

附录:单路/双路Xeon规格表

Penryn/Harpertown Xeon规格对照表

Nehalem-EP/Nehalem-WS Xeon规格对照表

Westmere-EP Xeon规格对照表

我们收到的Nehalem-EX平台是4U规格,四路Nehalem-EX Xeon X7560和64个DIMM共256GB内存,比较少见的是在笔者的要求下,Intel提供了两个64GB的X25-E固态内存;整台机器由Intel和Quanta打造:

4U机架,前面版主要被4个风扇的进风口占据了

8个2.5"热插拔硬盘槽i和一个笔记本DVD-RW(还能刻录哦)

可以接2.5"的SAS硬盘,也可以接SSD……

数数,背后一共提供了11个空余全高挡板的位置,不过,其中最左边一条被一块O自LSI 9260-8i的阵列卡占用了(抱歉……Intel的型号实在记不住),剩下的十个插槽中有一条是PCIE 2.0 x16规格,其它的全部是x8规格

使用了4个冗余电源,确保机器可以全天候365天稳定运行(模拟线路的电源是电脑中故障率较高的部件)

台达出品,850W,因此要两个协同工作才能支撑整台服务器满负荷运行(后面我们可以看到机器的功耗需求)

打开机盖,可以⑾郑?蟛糠值目占涠急荒诖孀酉低痴加昧耍?硪桓龃罂占湓蚴抢┱箍ㄇ?洌??诖媲胺绞?个热插拔冗余暴力风扇模块,后方是处理器区域

内存模块上有众多的指示灯指示内存DIMM的工作状态,还有一个ATTN Button按钮,要进行热操作的时候需要用到

8个热插拔内存模块,每个模块对应CPU的一个内存控制器(SMI界面),使用两个SMI Link;每个内存模块里面有两个SMB芯片和一共8条内存

拿下所有内存模块之后,机器空了很多

使用的内存条除了芯片比较多之外没有什么特别之处;可能比较有趣的是,它们都是DDR3-1333规格的,不过在Nehalem-EX上只能运行在DDR3-1066

机器最中央的就是四个Nehalem-EX处理器的位置了

螺丝固定的高塔热管铜底铝片散热器

CPU与插槽

Nehalem-EX Xeon X7560……工程样品

八核心2.27GHz Nehalem-EX

上一代:六核心45nm Penryn Dunnington??Xeon 7400系列处理器

实际上,这台机器的网络子系统和显示、串口等IO系统是集成在同一块扩展卡上的:

很特别的插槽

四个千兆网口、一个VGA接口和一个9针串口

三个大芯片

SE-SM4210-P01实际上是一个集显示、IPMI/KVM等为一体的芯片,采用的显示核心为Matrox G200eW,它右边为其工作内存

Intel 82576NS网络芯片,代号Kawela,576NS是576EB的简化版,NS就是Non-Security的意思,它没有了IPsec Offload功能,除此之外如16/16 TX/RX Queue、8 RSS Queue以及8 VMDq Queue功能都保留了下来,关于这些特性的介绍,可以看这里:

Intel新一代千兆万兆网卡芯片选购宝典

Intel RS2BL080阵列卡,长的就和LSI MegaRAID 9260-8i阵列卡一模一样

PCI Express 2.0 x8接口;这个阵列基于800MHz的PPC 440处理器,512MB缓存

8个SAS 6Gb/s接口,支持RAID 0/1/3/5/6等

两个Intel X25-E固态硬盘,64GB,SLC芯片,企业规格

型号SSDSA2SH064G1GC,Firmware版本是8860,单价约是¥6000

测试在IT168评测中心新网络实验室机房进行,网络实验室的Cisco Catalyst 4506千兆交换机目前已经升级到3个模块,达到了一共120个千兆网络端口,还新购买了30台DELL PowerEdge T100服务器,配合原有的30台DELL PowerEdge SC430服务器以及30台PC作为网络测试的客户端,可以提供非常充足的测试压力。

网络实验室控制台

网络实验室机房

Cisco Catalyst 4506千兆交换机,120个千兆铜口

部分 PowerEdge SC430服务器

快速导航

4路32核64线程 顶级Nehalem-EX平台评测(上篇)

4路32核64线程 顶级Nehalem-EX平台评测(中篇)

4路32核64线程 顶级Nehalem-EX平台评测(下篇)